Der Beitrag ist sehr lang, 74.300 Zeichen, um genau zu sein. Im ersten Abschnitt folgt daher eine kurze Einleitung und Zusammenfassung – in Abschnitt zwei folgt der gesamte Text. So, wie er im atw-Journal Ende 2024 erschien. Mit einem ausführlichen Grundlagenkapitel zu den technischen und physikalischen Grundlagen der Systemstabilität.

Teil Eins – Einleitung und Zusammenfassung

Deutschland verfolgt einen Sonderweg. Als einzige große Industrienation der Welt unternimmt das Land den Versuch, seine Energieversorgung ausschließlich auf fluktuative Erneuerbare Energien auszurichten. Der Erfolg bleibt bisher vollkommen aus. Im Jahr 2024 war Deutschland nach Polen und Tschechien in nahezu allen Monaten die Industrienation mit den dritthöchsten CO2 Emissionen im Energiesektor in der EU. Selbst im August, der 15 % mehr Sonnenstunden hatte als in Vergleichszeiträumen, hatte Deutschland mit 303 g CO2eq/kWh eine im Vergleich zu den anderen großen Industrienationen, Spanien, Frankreich und Großbritannien, eine ausgesprochen mittelmäßige Bilanz. Lediglich Italien kam mit 295 g CO2eq/kWh auf einen ähnlich schlechten Wert. Überhaupt ist auffällig, dass der Zubau an Erneuerbaren in den vergangenen Jahren nur sehr begrenzt positive Auswirkungen auf die CO2 Bilanz hat. Für das Jahr 2023 kam der Thinktank Agora Energiewende zu dem Ergebnis: “ nur rund 15 Prozent des CO₂-Rückgangs [sind] langfristige Einsparungen, die sich vor allem aus dem Zubau Erneuerbarer Energien, Effizienzsteigerungen sowie dem Umstieg auf CO₂-ärmere oder klimafreundliche Brennstoffe beziehungsweise Alternativen ergeben“.

Der Rest resultiert aus der Abwanderung von Industrie, weniger Produktion und Wohlstandsverlust. Das Energienetz und die Versorgung mit zuverlässiger Energie ist wesentlich komplexer und schwieriger, als allgemein häufig kommuniziert wird. Mit der Energiekrise rückte das Thema Netzstabilität zunehmend in den Mittelpunkt des politischen Interesses. Ende 2023 veröffentlichte das BMWK mit der Roadmap Systemstabilität erstmals ein offizielles Papier vor, das die Anforderungen beim Umstieg von Synchronmaschinen auf Leistungselektronik beschreibt.

Dies geschieht auf Grundlage der Annahme eines zu 100 % auf Erneuerbaren Energien basierenden Energiesystems. Technisch liefert das Papier eine solide Grundlage und beschreibt Entwicklungsprozesse, die für einen stabilen Netzbetrieb mit leistungselektronischen Anlagen notwendig sind. Während die Aufgaben und Herausforderungen gut beschrieben werden, weist die Roadmap aber auch eklatante Schwächen auf: Die formulierten Zeitpläne sind vollkommen unrealistisch, die Risikobewertung ist strukturell wie fachlich in kritischem Maße unzureichend und der Komplexität des Gesamtprozesses wird kaum Rechnung getragen. Insbesondere die Anforderungen an die Regelung und Netzintegration leistungselektronischer Anlagen wird nicht seriös auf Basis des heutigen Ist-Zustands und der Betriebsrealität von über 800 Netzbetreibern in Deutschland diskutiert. Zwar werden Ziele und Aufgabenpakete benannt, bei der Behandlung des hieraus abzuleitende Arbeitsumfang bleibt das Papier jedoch unterkomplex und eindimensional. Auch vernachlässigt die Roadmap die Herausforderungen, die der Mangel an Fachkräften, die Anforderungen an die Cyber-Security und der notwendige Ausbau der Netzinfrastruktur mit sich bringen.

Es ist evident, dass der vorgegebene Zeitrahmen unter politischem Druck festgelegt wurde, obwohl die technische Machbarkeit deutlich länger erfordert. In diesem Sinne könnte man die Zeitplanung zutreffend als vollkommen unseriös, überstürzt und undurchdacht bezeichnen.

Der Umstieg auf eine emissionsarme Energieversorgung und die Stärkung des ingenieurwissenschaftlichen Knowhows in diesem Bereich ist zentral für den Wirtschaftsstandort Deutschland. Ein überstürzter Wandel, ohne der Dauer von Forschungs- und Entwicklungsprozessen angemessen Rechnung zu tragen, könnte die Versorgungssicherheit in Deutschland ernsthaft gefährden und so das Ziel einer stabilen, emissionsarmen Energieversorgung konterkarieren.

Weiterhin versagt das Papier auf Ebene der Verwaltung und Arbeitsstrukturen. Der Übergang zu einem von Leistungselektronik dominierten, dezentral aufgebauten Energiesystem, bringt nicht nur technische und physikalische Herausforderungen mit sich, sondern erfordert auch einen tiefgreifenden Wandel in der Zusammenarbeit zwischen Netzbetreibern, Regulierungsbehörden und der Industrie.

Die getroffenen Aussagen erwecken möglicherweise den Eindruck einer überwiegend negativen Rezension der Roadmap Systemstabilität. Dies möchte ich hier noch einmal differenzieren. Die Roadmap Systemstabilität liefert ein hervorragendes technisches Grundlagenwerk und formuliert erstmals die, für das genannte Szenario, notwendigen Entwicklungsschritte in Prozesse. Formuliert wird aber auch eine völlig überzogene, unterkomplexe und unseriöse Erwartungshaltung, die zentrale Fragestellungen unbeantwortet lässt und sich in unbelegte Behauptungen flüchtet.

Zum Schluss ein persönliches Wort: Ich bin im Ruhrgebiet zwischen den Hinterlassenschaften des Bergbaus aufwachsen, habe Tagebrüche erlebt und die Folgen von jahrzehntelanger Kohleverstromung gesehen. Darunter leidet das Ruhrgebiet bis heute. Man denke an die Belastungen der Böden und den politisch völlig verpatzten Strukturwandel. Der Umstieg auf eine möglichst emissionsfreie und ressourcenschonende Energieerzeugung ist alternativlos und nicht nur maßgeblich für den Wirtschaftsstandort Deutschland, sondern auch für den Umweltschutz weltweit. Wenn die in der Roadmap formulierten Prozesse und Ziele genutzt würden, um Innovationen anzustoßen und die ingenieurwissenschaftliche Kapazität Deutschlands zu stärken, dann wäre viel erreicht. Dies kann aber unmöglich auf Kosten eines sicheren, zuverlässigen Systembetriebs geschehen. Dem entgegen stehen auch Verpflichtungen Deutschlands auf europäischer Ebene, auf die hier aber nicht weiter eingegangen werden soll.

Hierfür ist aber Realitätssinn bei der Umsetzung, bei der Beurteilung von Zeitplänen und insbesondere der Risikobewertung notwendig. Die Physik hat kein Parteibuch. Forschungs- und Entwicklungsprozesse lassen sich, auch mit Geld, nicht beliebig beschleunigen. Der denkbar größte Schaden, der sich dem Ziel des Umstiegs auf emissionsarme Energieerzeuger zufügen ließe, wäre ein Blackout, ein unplanbarer, unzuverlässiger Systembetrieb oder aber reale Schäden an Leib und Leben.

Und an dieser zentralen Stelle und der Frage, wie zuverlässige elektrische Energie zukünftig zur Verfügung stehen soll, wird die Roadmap Systemstabilität den anstehenden Aufgaben nicht gerecht.

Teil Zwei – Die Herausforderung der Systemstabilität: Wie der Übergang zu Erneuerbaren Energien unser Stromnetz revolutioniert – und welche Risiken dabei drohen

Abstract

Bleibt unser Stromnetz auch in Zukunft stabil? Das ist eine existenzielle und anspruchsvolle Frage. Der vorliegende Artikel bemüht sich um Klärung. In einem ausführlichen Grundlagenkapitel werden zunächst die technischen und physikalischen Grundlagen der Systemstabilität im elektrischen Energienetz dargestellt. In diesem Zusammenhang wird auch auf systemtheoretische Überlegungen sowie physikalische Phänomene wie beispielsweise Nichtlinearität eingegangen. Erläutert werden dann zentrale Herausforderungen, die der Umstieg von Synchronmaschinen auf leistungselektronische Erneuerbare Energie-Anlagen mit sich bringt.

Aufbauen hierauf wird nachfolgend die vom BMWK veröffentliche „Roadmap Systemstabilität“ kritisch diskutiert. Positiv hervorgehoben werden die in der Roadmap dargestellten technischen Grundlagen sowie die Aufgabenbeschreibung, kritisiert werden jedoch die völlig unrealistischen Zeitpläne, die unterkomplexe Darstellung der Risiken sowie die Vernachlässigung der Anforderungen an Stromrichter, beziehungsweise deren Regelung. Außerdem wird betont, dass die Herausforderungen der Digitalisierung massiv unterschätzt werden.

Abschließend wird für einen realistischen, risikobewussten Ansatz plädiert, der die physikalischen Grenzen und den Bedarf an Forschung und Entwicklung anerkennt. Der Artikel betont, dass ein überstürzter Wandel ohne ausreichende Risikobewertung die Versorgungssicherheit gefährden könnte und ruft zu einer ausgewogenen Balance zwischen ambitionierten Zielen und praktikablen Lösungen auf. Vorschläge zur strukturellen Umsetzung sowie technische Anforderungen an Netzregelung und Leistungselektronik werden formuliert.

Hauptteil

Ende 2022 waren die Begriffe „Energiekrise“ und „Blackout“ in aller Munde. Medial stark aufgeheizt entstand der Eindruck, dass die Stabilität unseres Energienetzes bedroht sei. Mit dem Wegfall der Gasimporte aus Russland, so die damalige Sorge, stünde möglicherweise nicht mehr genügend Brennstoff zur Versorgung von Gaskraftwerken zur Verfügung, die vor allem durch ihre schnelle Regelfähigkeit für die Netzstabilität essenziell sind.

Tatsächlich bestand ein gewisses Risiko, dass Gasvorräte zur Versorgung von Kraftwerken hätten rationiert werden müssen. Trotzdem war die Sorge vor einem Blackout, angesichts der verfügbaren thermischen Kraftwerkskapazitäten, übertrieben. Davon unabhängig war die Stabilität des Energienetzes zum Thema geworden und das hat sich auch bis heute nicht geändert.

In diesem Zusammenhang ist auch die im Dezember 2023 vom BMWK veröffentlichte Roadmap Systemstabilität von Bedeutung. Diese soll als Fahrplan zur Erreichung „eines sicheren und robusten Betriebs des zukünftigen Stromversorgungssystems mit 100% Erneuerbaren Energien“ gelesen werden. Auf mehr als 100 Seiten werden Problemstellungen umrissen, die bis heute größtenteils ungeklärt sind und zum Großteil in den nächsten 6 Jahren in Forschungs- und Entwicklungsaufträgen abgehandelt und idealerweise in praktische Lösungen überführt werden sollen. Das ist nachvollziehbar: Seit vielen Jahren wird nämlich in Fachkreisen angemerkt, dass mit dem zunehmenden Umstieg auf leistungselektronische Erzeugeranlagen der Systemstabilität immer größere Bedeutung zukommt. Diesem, bisher größtenteils vernachlässigten, Thema trägt die Roadmap nun Rechnung. Technisch und strukturell ist das Papier dabei von solider Qualität. Es lässt jedoch auch erheblichen Raum für Kritik und lässt zentrale Problemstellungen. Das soll im vorliegenden Artikel ausgeführt werden.

Der Beitrag gliedert sich in vier Abschnitte:

Im ersten Abschnitt werden die technischen und physikalischen Grundlagen des Begriffs „Systemstabilität“ detailliert erläutert. Dabei wird tiefgehend auf Stabilitätskonzepte, wie Frequenz- und Spannungsgleichgewicht, sowie die Rolle von Synchronmaschinen eingegangen.

Der zweite Abschnitt beschäftigt sich mit den Unterschieden bei der Netzankopplung von Synchronmaschinen und Leistungselektronik.

Der dritte Abschnitt ist als Exkurs zu verstehen, der sich mit linearen und nichtlinearen System beschäftigt und hilfreich ist, um ein tiefgreifenderes Verständnis für die Problemstellungen und Herausforderungen zu entwickeln.

Der vierte und umfassendste Abschnitt analysiert, bewertet und kommentiert die „Roadmap Systemstabilität“. Außerdem werden strukturelle und technische Vorschläge formuliert, um den Anforderungen an die Netzstabilität und den Transformationsprozess besser zu erfüllen.

Vorab: Wenn im Artikel von „Energienetzen“ die Rede ist, dann ist das elektrische Wechselspannungs(AC)-Energienetz gemeint.

1. Technische Grundlagen, Netzphysik und Netzstrukturen

Was bedeutet eigentlich „Systemstabilität“?

Betrachten wir einmal ein Kartenhaus, das direkt neben einem massiv gemauerten Einfamilienhaus steht. Im Vakuum und ohne externe Einflüsse wären die beiden Systeme „Kartenhaus“ und „gemauertes Haus“ statisch stabil und würden bis in alle Ewigkeit fortbestehen. Kommt nun auch nur geringer Wind hinzu, wird das Kartenhaus umfallen, während das gemauerte Haus die kinetische Belastung unproblematisch übersteht. Das System „gemauertes Haus“ ist robust gegen den äußeren Einfluss, sprich widerstandsfähig. Tritt nun ein massiver Orkan oder Wirbelsturm auf, wird auch das gemauerte Haus irgendwann an Belastungsgrenzen kommen und zerstört werden. Die Robustheit des Systems „gemauertes Haus“ hat somit Grenzen, bis zu denen äußere Einflüsse dem System keinen Schaden zufügen können.

Während sich im vorgenannten Beispiel lediglich eine Einflussgröße, der Wind, ändert, ist das elektrische Energienetz ungleich komplexer. Im Energienetz interagieren eine Vielzahl von Erzeugern und Verbrauchern, wobei sich Erzeugung und Verbrauch ständig ändern, aber gleichzeitig permanent ausgeglichen sein müssen. Weiterhin tritt Blindleistungspendelung auf, die zwar in gewissem Maße gewünscht ist, zeitgleich aber das Netz sowie die angeschlossenen Betriebsmittel belasten kann und somit in der Gesamtbetrachtung berücksichtigt werden muss. Hier sind zunächst einige mit dem Begriff „Netzstabilität“ assoziierte Begriffe zu definieren:

Leistungsgleichgewicht

Zur Wahrung der Frequenz- und Spannungsstabilität muss die eingespeiste Leistung in einem elektrischen Netz zu jedem Zeitpunkt der abgenommenen Leistung entsprechen. Weiterhin müssen Transportkapazitäten gegeben sein, um die benötigte Leistung im Netz zu verteilen. Das Vorhalten hinreichender und steuerbarer Erzeugerleistung wird als Erzeugeradäquanz, das Vorhalten von Transportkapazitäten als Netzadäquanz bezeichnet.

Es ist offensichtlich, dass diese Aufgabe durch fluktuierende Einspeisung zusätzlich erschwert wird. Je höher der Anteil fluktuativer Erzeuger ist, desto bedeutender ist die Netzzustandsanalyse.

Dynamische Stabilität und Anpassungsfähigkeit

Das Energienetz ist ein dynamisches System, dessen Zustand sich permanent ändert. Ziel des Systems ist es, für jeden Leistungsbedarfszustand eine auskömmliche Speisung unter Einhaltung von technischen Restriktionen sicherzustellen. Hieraus ergibt sich ein dynamisches Gleichgewicht.

Ein System ist dann stabil, wenn dieses, innerhalb gewisser Randbedingungen, auf jede zu erwartende und unerwartete Zustandsänderung/Störung eine angemessene, robuste Reaktion zeigen kann, ohne, dass das System instabil wird. Maßgeblich sind hier die in der IEC 60038 sowie EN 50160 definierten Kenngrößen und insbesondere die Netzfrequenz von 50 Hz.

Hierzu muss jederzeit sichergestellt werden können, dass das System, auch bei einer Störung oder Zustandsänderung kontrollierbar bleibt und nicht eskaliert, sprich keine Kettenreaktion ausgelöst wird, die zum Zusammenbruch des Systems führen könnte. Abweichungen und Pendelbewegungen, wobei das System in der Nähe des idealen Betriebspunktes gehalten wird, sind bewusst vorgesehen. Ein solches System wird als Lyapunov-stabil bezeichnet.

Das gesamte System muss zudem in der Lage sein, sich kontinuierlich so anzupassen, dass es für jeden vorgesehenen Betriebs- und Bedarfszustand einen Arbeitspunkt erreicht, der das System in der Nähe des theoretischen Optimums hält. Es muss also adaptiv, sprich anpassungsfähig sein.

Schnell wird klar, dass zwischen den einzelnen Aspekten ein direkter Zusammenhang besteht. Zusammenfassend sollte der Begriff „Systemstabilität“ daher weit gefasst die Aspekte Adäquanz, Lyapunov-Stabilität und Adaptivität berücksichtigen.

Netzdienstleistungen, Power Quality und Betriebssicherheit

Aus den zuvor beschriebenen, größtenteils theoretischen Darstellungen und Erwägungen folgen im realen Netzbetrieb eine Reihe an Anforderungen. Auf einige Aspekte soll im Folgenden eingegangen werden. Neben einigen weiteren Aspekten sind die nachfolgend aufgeführten vier Punkte maßgebliche Kenngrößen der „Power Quality“:

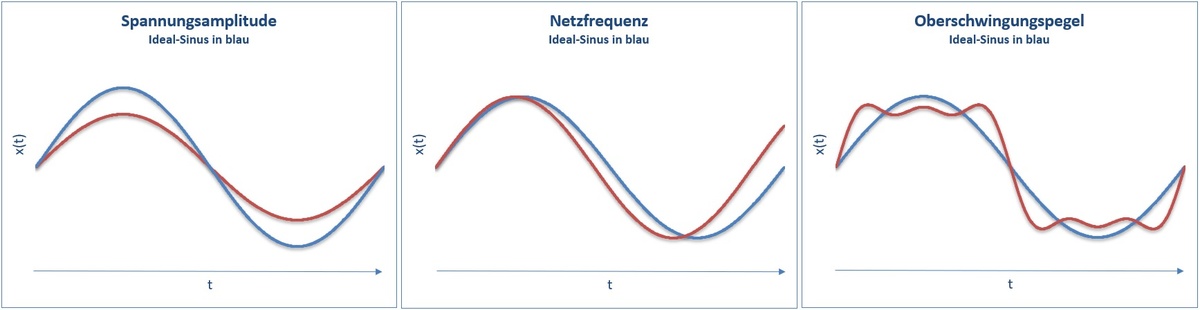

- Strom und Spannung im Wechselspannungssystem werden über eine Sinus-Kurve beschrieben. Spannungshaltung, sprich die Einhaltung der vorgesehenen jeweiligen Nennspannung, ist elementar um die bedarfsgerechte Versorgung von Verbrauchern sowie einen betriebsmittelgerechten Betrieb sicherzustellen.

- Die Netzfrequenz ist die wichtigste Kenngröße des Energienetzes, da die meisten Verbraucher auf sie ausgerichtet sind. Das bedeutet, dass die Verbraucher nur bei einer Frequenz von 50 Hz innerhalb eines bestimmten Toleranzbandes bestimmungsgemäß arbeiten. Sinkt oder steigt die Netzfrequenz außerhalb des vorgesehenen Bandes, können zahlreiche Geräte nicht mehr ordnungsgemäß arbeiten und es kommt zu Störungen oder im schlimmsten Fall Schäden und Ausfällen. Dies betrifft insbesondere auch die netzeinspeisenden Synchronmaschinen thermischer Kraftwerke selbst. Die Netzfrequenz fällt ab, wenn die benötigte Leistung höher ist, als die erzeugte Leistung und steigt an, wenn die erzeugte Leistung höher ist als die benötigte Leistung. Bis ein solcher Effekt im Netz spürbar wird, vergehen nur wenige Millisekunden. Das zulässige Frequenzband ist 50,2 bis 49,8 Hz. Auf Schwankungen wird mit so genannter Regelleistung reagiert. Hierbei wird zwischen der instantan reagierenden Momentanreserve, der automatisiert eingesetzten Primärregelleistung und der manuell aktivierten Sekundär- und Tertiärregelleistung unterschieden. Kann das Frequenzband trotz dieser Maßnahmen nicht eingehalten werden, erfolgt ein automatisierter Lastabwurf, bis die Stabilität wiederhergestellt ist. Sollte dies bis 47,5 Hz nicht gelingen, würden sich alle Betriebsmittel zum Eigenschutz abschalten und es käme zu einem Systemzusammenbruch, einem sogenannten Blackout. Damit nicht das gesamte System kollabiert, gibt es bereits weit vorher Sollbruchstellen, die die Ausbreitung der Großstörung und des Blackouts begrenzen sollen.

- Damit sich Betriebsmittel im Verbund auslegungsgemäß verhalten, dies können sowohl Erzeuger, Verbraucher aber auch sonstige Komponenten sein, ist die Reinheit der Sinuswelle von großer Bedeutung. Neben der Ermöglichung eines ausgleichsstromfreien Zuschaltens im Nulldurchgang betrifft dies auch den Betrieb im synchronen Zustand. Relevant sind hierbei vor allem sogenannte Harmonische oder Oberwellen (häufig synonym genutzt mit Oberschwingungen), dies sind ganzzahlige Vielfache der Grundschwingung, die als unerwünschte Einkopplung ins Netz die Sinuswelle verzerren. Ursächlich hierfür sind Bauteile mit nichtlinearen Kenngrößen, Komponenten mit nicht-sinusförmigen Strömen oder auch Leistungselektronik wie Gleich- und Wechselrichter. Viele Anlagen besitzen heute Filteranlagen und können so mit verzerrten Sinuswellen in einem gewissen Rahmen arbeiten. Es gilt: Je unsauberer die Sinuswelle ist, desto wahrscheinlicher wird es, dass Anlagen nicht mehr auslegungsgemäß arbeiten und mit dem Netz synchronisiert werden können oder aber ihre Synchronität verlieren.

- Im dreiphasigen Netz besteht folglich eine Sinuskurve je Phase. Diese Phasen sind um jeweils 120° gegeneinander verschoben und symmetrisch. Um eine auslegungsgemäße Funktion von Anlagen im Drehstromsystem zu gewährleisten, muss somit der Reinheit jeder der drei Sinuskurven sowie der Phasensymmetrie Rechnung getragen werden.

Links: Verschiebung der Amplitude (rot) zeigt Unterspannung gegenüber der Sollspannung an; Mitte: Verschiebung des Sinus nach links zeigt Frequenzüberhöhung gegenüber der Sollfrequenz an; Rechts: Verlagerungen der Sinuskurve (rot) zeigen erhebliche harmonische Verzerrungen an.

Der Aufbau des Energienetzes hat verschiedene Ebenen, die kurz vereinfacht beschrieben werden.

- Die Höchstspannung (Netzebene 1), also die 380/220 kV-Ebene, dient der Übertragung von Leistung über große Distanzen im europäischen Verbundsystem sowie dem Anschluss thermischer Großkraftwerke, beispielsweise Kernkraftwerken.

- Die Hochspannung, die 110 kV-Ebene (Netzebene 2), dient der Verteilung über regionale Distanzen sowie der Versorgung großer Industriekunden. Weiterhin werden auf dieser Ebene Kraftwerke mittlerer Leistungsklasse angeschlossen.

- Darunter folgen verschiedene Mittelspannungsebenen (Netzebene 5), deren Spannungsniveau sich häufig nach regionalen Anforderungen richtet und/oder historische Gründe hat und deren Zweck die Versorgung von Industriekunden sowie der nachgelagerten Ortsnetze ist. Weiterhin sind hier städtische und kleinere Kraftwerke angeschlossen.

- Die niedrigste Spannungsebene, die 400 Volt (Netzebene 7), versorgt Haushalte sowie kleinere Betriebe. Ein Anschluss von Einspeisern war auf dieser Ebene ursprünglich nicht vorgesehen. Dies hat sich jedoch mit dem Ausbau von Photovoltaikanlagen massiv geändert.

- Die Netzebenen 2, 4 und 6 beschreiben die Umspannung zwischen der jeweils genannten höheren und niedrigeren Spannungsebene.

Die hierarchische und historisch aus der Zeit der Großkraftwerke stammende Planungslogik des Energienetzes war jene, dass idealerweise ein leistungstechnisches Top-Down-Prinzip verfolgt wird, sprich Leistung aus überlagerten Netzebenen runtergespannt wird und so Netzebenen niedriger Spannungsniveaus versorgt. Idealerweise sollte es nicht zu einer Rückspeisung aus unterlagerten Netzebenen in vorgelagerte Netzebenen kommen. Der Ausbau der jeweiligen Netzebenen sowie die vorgehaltene Netzadäquanz richtete sich hierbei nach dem historisch begründeten Zweck.

Mit dem Aufkommen dezentraler Energiequellen wie Photovoltaikanlagen, Windkraftanlagen und kleinen Blockheizkraftwerken verändert sich diese Dynamik grundlegend. Diese Einspeiser befinden sich häufig auf den unteren Spannungsebenen, wie der Mittel- oder sogar Niederspannungsebene, was das klassische Top-Down-Prinzip aushebelt. Die Rückspeisung von Energie in höhere Spannungsebenen, die in der Vergangenheit vermieden wurde, ist heute gang und gäbe, da viele kleine, dezentrale Quellen oft mehr Energie produzieren, als lokal benötigt wird.

Es ist daher offensichtlich, dass hieraus gänzlich neue Anforderungen an die Betriebsführung sowie das Netzmonitoring folgen, die in Kapitel 2 im Kontext der Roadmap Systemstabilität diskutiert werden.

Das europäische ENTSO-E Netz wurde bisher zu einem Großteil über thermische Kraftwerke bzw. Synchronmaschinen gespeist. Die Regelbarkeit sowie die Leistungsfähigkeit der Kraftwerke liefern die zuvor beschriebene Erzeugeradäquanz und Adaptivität.

Das Trägheitsmoment der rotierenden Masse bietet durch die physikalisch direkte, synchrone Koppelung mit dem Netz eine inhärente Momentanreserve und wirkt somit bei kurzzeitigen Leistungsschwankungen stabilisierend (Leistungsgradient positiv & negativ). Die Synchronmaschine wandelt, bedingt durch die physikalische Masse, im Falle eines zusätzlichen Leistungsbedarfs kinetische Energie in elektrische Energie und ebenso, im Falle eines übermäßigen Leistungsangebotes, elektrische Energie in kinetische Energie um.

Weiterhin sind Synchronmaschinen in hohem Maße überstromfähig und können daher im Fehlerfall hohe Kurzschlussströme liefern, die die Fehlererkennung verbessern. Zusätzlich sorgt die mechanische und elektromagnetische Dämpfung in Synchronmaschinen für eine Gegenkraft gegenüber unerwünschten Schwingungen und „glätten“ somit die Sinuswelle. Mechanische Dämpfung führt dazu, dass die Oberwellen im Rotor durch Widerstand und Trägheit gedämpft werden, und die dabei absorbierte Energie in Wärme umgewandelt wird. Elektromagnetische Dämpfung wirkt auf die Wechselwirkung zwischen elektrischen Strömen und Spannungen im Stator und Rotor, was ebenfalls zu einer Dämpfung führt. Der auf Synchronmaschinen gestützte Netzbetrieb ist heute essenziell dafür, dass das System Lyapunov-stabil bleibt.

Mit dem zunehmenden Ausbau von Erneuerbaren Energie(EE)-Anlagen wird das Gesamtsystem immer komplexer. Diese sind, anders als bisher dominierende konventionelle thermische Kraftwerke mit rotierenden Generatoren, über Leistungselektronik mit dem Netz gekoppelt. Hierbei kommt es zu einer Reihe von elektrotechnischen dynamischen Phänomenen, deren Auswirkungen auf die Stabilität im Gesamtverbund deutlich intensiver untersucht und überwacht werden müssen, als dies bei konventionellen Kraftwerken bisher der Fall war. Leistungselektronik verursacht durch nicht-sinusförmige Schaltvorgänge, nichtlineare Bauelemente, Streukapazitäten sowie schnelle Strom- und Spannungsänderungen Oberwellen/harmonische Einkopplungen im Energienetz. Diesen kann in bedingtem Maße über Oberwellenfilter begegnet werden, insgesamt beeinflussen diese die Power Quality jedoch in erheblichem Maße.

Weiterhin sind die für den Bau von Leistungselektronik verwendeten Halbleiter nur in einem sehr engen Maße überstromfähig. Im Kurzschlussfall steht daher nur ein gegenüber der Synchronmaschine deutlich reduzierter Kurzschlussstrom zur Verfügung. Dies ist nicht nur für die Erkennung von Kurzschlüssen im Netz nachteilig, es drohen auch erhebliche Spannungseinbrüche im Netz, die zu Spannungstrichtern und somit massiven Leistungstransiten führen können. Während sich, bedingt durch die direkte Kopplung zum Netz, bei einer Synchronmaschine physikalisch automatisch ein Fehlerstrom einstellt, muss der fehlerhafte Netzzustand von leistungselektronischen Komponenten erkannt werden, um Fehlerströme zu speisen.

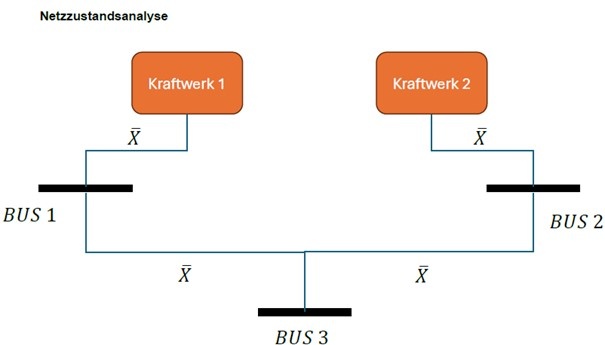

Gezeigt wird ein klassisches 3-BUS („ein Anschluss“) System mit zwei Einspeisern (Abbildung 2). Zwischen jedem Bus liege eine komplexe Impedanz X, jeder BUS habe eine variierende Leistungsabnahme.

Im konventionellen Speisefall, unter Vernachlässigung der Netzverluste, über zwei Kraftwerke war das Gleichgewicht definiert als

–(𝐵𝑈𝑆 1 + 𝐵𝑈𝑆 2 + 𝐵𝑈𝑆 3) + 𝐾𝑊 1 + 𝐾𝑊 2 = 0

Jedes Kraftwerk speist auf eine komplexe Impedanz, wobei sich die gespeiste Impedanz bei synchronem Betrieb beider Kraftwerke nicht ändert. Über den Erregerstrom der Synchronmaschine wird die zur Spannungshaltung notwendige Blindleistung zur Verfügung gestellt. Bei einer Veränderung der Leistungsbilanz (BUS 1 bis BUS 3) resultiert eine Veränderung der Netzfrequenz, die Massenträgheit der Synchronmaschine bietet den notwendigen Zeitpuffer, um seitens des Kraftwerksbetriebs hierauf zu reagieren.

Stellen wir uns nun vor, dass jeder BUS volatil ebenfalls zu einem Einspeiser werden kann, bspw. in Form einer großen PV-Anlage. In Abhängigkeit der zur Verfügung gestellten Systemdienstleistungen sind verschiedene Szenarien vorstellbar.

Angenommen, BUS 1 speist intermittierend hohe Wirkleistung. Es resultiert eine Spannungshebung an BUS 1, die Kraftwerk 1 dazu zwingt, instantan in den Phasenschieberbetrieb zu wechseln, Kraftwerk 2 wäre gezwungen, ebenfalls den Winkel zu korrigieren und die Leistungsbilanz des BUS-Systems auszugleichen. Für die regelbaren Kraftwerke ändert sich die zu speisende komplexe Impedanz nahezu unprognostizierbar.

Während Synchronmaschinen die zuvor beschriebene Netzrobustheit durch Massenträgheit und Dämpfung erlauben, erfordert der beschriebene Ausgleich über Leistungselektronik ein erhebliches Maß an zusätzlichen Informationen sowie Puffern, um natürliche Erzeugungsschwankungen bei Wind und PV (Photovoltaik) auszugleichen. Weiterhin muss das genaue Verhalten der leistungselektronischen Komponenten in jedem Arbeitspunkt spezifiziert sein. Dies umfasst auch den Beitrag an notwendigen Systemdienstleistungen jedes Einspeisers.

2. Netzankopplung: Synchronmaschine vs. Leistungselektronik

Der nachfolgende Abschnitt beschreibt vereinfacht die schematische Anbindung sowie die technischen Grundlagen und Unterschiede bei der Netzankopplung von konventionellen Kraftwerken sowie modernen, auf Leistungselektronik basierenden Erneuerbaren Energieerzeugern (kurz EE-Anlagen).

Bei thermischen (konventionellen) Kraftwerken wird ein Wasser-Dampf-Kreislauf genutzt, um ein Gefälle zwischen hohem und niedrigem Druck zu erzeugen (Kraft/Energie), welches eine Turbine antreibt (Abbildung 3). Der obere Teil der Grafik zeigt den grundsätzlichen physikalischen Aufbau, der untere Teil überträgt diesen auf konventionelle Kraftwerke. Der hohe Druck wird im durch den Brennstoff beheizten Verdampfer hergestellt. Hinter der Turbine wird die nicht in mechanische Energie umwandelbare Abwärme durch einen Kondensator entnommen. Der mit der Turbine auf einer gemeinsamen Welle drehende Generator (die Synchronmaschine) wandelt die mechanische Energie sodann in elektrische Energie um und ein Blocktransformator bringt diese dann auf das Spannungsniveau des Netzes. Wirkleistung (P) und Blindleistung (Q) werden hierbei in Abhängigkeit vom Polradwinkel und Erregerstrom an das Stromnetz abgegeben.

Durch die Rotation der Synchronmaschine, die eine Kreisbewegung vollführt, entsteht ein idealer sinusförmiger Wechselstrom. Entscheidend ist, dass die physikalische, direkte Ankopplung der Synchronmaschine erhebliche netzdienliche Eigenschaften aufweist. Die Rotation der Synchronmaschine speichert kinetische Energie, die im Bedarfsfall an das Stromnetz abgegeben werden kann. Übersteigt der Energiebezug aus dem Stromnetz die Energie aus dem Primärkreislauf, sinkt die Rotationsgeschwindigkeit der Synchronmaschine allmählich. Dies würde zu einem langsamen Absinken der Netzfrequenz führen.

Bei einem Leistungsüberangebot im Stromnetz nimmt die Synchronmaschine elektrische Energie auf und wandelt diese in Rotationsenergie um, wodurch die Drehzahl der Maschine steigt. Dies führt zu einem allmählichen Anstieg der Netzfrequenz.

Im Fehlerfall, beispielsweise bei einem Kurzschluss, kann kurzfristig eine sehr hohe Leistung bereitgestellt werden. Dies resultiert in hohen Fehlerströmen und unterstützt die Fehlererkennung. Die Abgabe dieser hohen Fehlerströme erfolgt sofort, da die Synchronmaschine physikalisch direkt angebunden ist. Die im Fehlerfall abgegebene Leistung kann dabei deutlich über der Nennleistung der Synchronmaschine liegen. Diese Fähigkeit wird als Überlastfähigkeit bezeichnet.

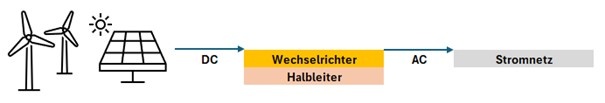

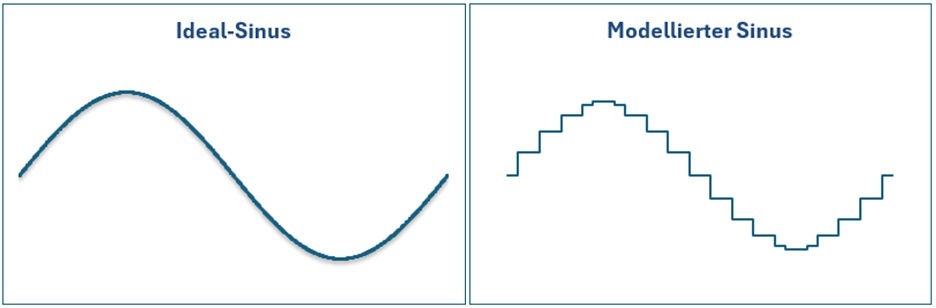

Wird eine PV-Anlagen (PVA), ein Batteriespeicher oder, mit Einschränkungen, eine Windkraftanlage (WKA)[1] an das Stromnetzangeschlossen (Abbildung 4), so liegt in der Regel zunächst eine Gleichspannung (DC) vor. Diese DC-Spannung wird mithilfe eines Wechselrichters in eine AC-Spannung umgerichtet. Hierbei werden Halbleiterbauteile über Pulse angesteuert und die Sinusform des Wechselspannungsnetzes nachmodelliert. Die Granularität der Schrittweiten bestimmt, wie fein die Nachbildung der Sinuskurve gelingt. Physikalisch handelt es sich jedoch um eine Treppenform und die Ausgangsspannung ist im Prinzip eine gepulste Gleichspannung, deren Amplitude möglichst ideal der Sinuskurve nachempfunden ist. Abbildung 4 zeigt einen idealtypischen Sinus gegenüber einem modellierten, treppenstufenartigen Sinus. Es sei angemerkt, dass die Abbildung der Veranschaulichung dient, die bei modernen Wechselrichtern real vorzufindende Modellierung der Sinuskurve ist bedeutend granularer und feiner.

Harmonische Verzerrungen tragen zur Abweichung vom Ideal-Sinus bei. Diese entstehen (Abbildung 1, Grafik unten links) unter anderem bei der Umwandlung von DC-Spannung in AC-Spannung. Verzerrungen resultieren aus der Tatsache, dass die erzeugte Wechselspannung nicht nur die Grundfrequenz des Netzes enthält (z. B. 50 Hz in Europa), sondern auch zusätzliche Frequenzanteile, sogenannte Oberwellen. Diese Oberwellen sind Vielfache der Grundfrequenz (100 Hz, 150 Hz, 200 Hz usw.) und entstehen durch das pulsierende Schalten der Halbleiterbauteile im Wechselrichter. Da die Nachbildung der Sinuskurve auf schnellen Ein- und Ausschaltvorgängen basiert, führt dies zu sprunghaften Änderungen der Spannung, die wiederum zusätzliche Frequenzen erzeugen. Diese Oberwellen verzerren die ideale Sinusform und sind ein unvermeidbarer Nebeneffekt des Schaltprozesses.

Die Aufgabe der Filter besteht darin, diese Oberwellen möglichst effektiv zu unterdrücken, sodass die resultierende Wechselspannung der Sinuskurve so nahe wie möglich kommt. Trotz dieser Filter bleibt jedoch immer eine geringe harmonische Verzerrung bestehen, da die hochfrequenten Schaltvorgänge nie vollständig eliminiert werden können. Ein perfekter Sinus kann daher niemals erreicht werden.

Halbleiter sind nicht überlastfähig, weiterhin richtet sich die maximale Leistungsabgabe nach der zur Verfügung stehenden, primären DC-Leistung, die wiederrum abhängig ist von der Sonneneinstrahlung oder der Windgeschwindigkeit. Eine theoretische, größere Überlastung von Halbleitern führt zur Zerstörung dieser. Folglich ist ersichtlich, dass die der Synchronmaschine inhärenten, netzdienlichen Eigenschaften nicht gegeben sind. Weder wird die Sinuswelle durch die Rotation automatisch erzeugt, noch kann im Fehlerfall ein hoher Fehlerstrom gespeist werden.

Moderne Wechselrichter sind heute in der Regel mit einer Fault Ride-Through (FRT) Funktionalität ausgestattet, um im Falle kurzzeitiger Netzfehler, beispielsweise bei Spannungseinbrüchen, am Netz zu bleiben und einen netzstabilisierenden Leistungsbeitrag zu liefern.

Sofern darüber hinaus ein Fehlerstrombeitrag gefordert würde, müsste hierzu:

- Die Anlage selbst oberhalb der Nennleistung ausgelegt sein, sodass im Fehlerfall zusätzliche Leistungsreserven zur Verfügung stehen.

- Eine Energiequelle vorgehalten werden, beispielsweise in Form einer Batterie, um im Fehlerfall unabhängig von volatilen Quellen Leistung zu speisen.

- Technische Vorrichtungen bestehen, um einen Fehlerzustand im Netz zu erkennen. Dies erfordert präzises Monitoring und eine zielgerichtete Regelung, die nach Erkennen des Fehlerfalls die Schaltung des entsprechenden Fehlerstrombeitrags veranlasst. Ein physikalisch bedingter Fehlerstrom, wie bei der Synchronmaschine, ist nicht gegeben.

Trotz der genannten Vorteile der Synchronmaschine, wie der Überlastfähigkeit und der netzstützenden Eigenschaften, bringt sie auch Nachteile mit sich. Synchronmaschinen sind mechanisch komplex und erfordern eine kontinuierliche Wartung. Zudem sind sie träge in ihrer Reaktionszeit auf Regelkreis- oder Arbeitspunktänderungen, da die Rotationsenergie nur allmählich angepasst werden kann. Dies kann in modernen Stromnetzen, die zunehmend schnelle Reaktionen erfordern, zu Nachteilen führen.

Im Gegensatz dazu bieten leistungselektronische Systeme wie Wechselrichter eine deutlich flexiblere und präzisere Steuerung der Energieeinspeisung. Sie können Arbeitspunktänderungen und Regelkreisoptimierungen nahezu in Echtzeit kompensieren und ermöglichen eine präzise Regelung der Einspeisung, unabhängig von der mechanischen Trägheit. Leistungselektronik ist somit, bezogen auf die Lastfolgefähigkeit, deutlich reaktionsschneller. Zeitgleich erfordern leistungselektronische Komponenten hochkomplexe Regelungsalgorithmen, um bedarfsgerecht auf unterschiedliche Netzzustände zu reagieren. Um das Verhalten von leistungselektronischen Anlagen vorab untersuchen zu können, sind komplexe Modelle der Anlagenregelung notwendig. Hierbei ist zwingend das Verhalten im Millisekunden-Zeitbereich zu untersuchen, da die Anlagen, wie zuvor beschrieben, keine inhärente, physikalische Glättung bieten und so eine Spezifizierung des Reaktionsverhaltens („der Regelung“) erfordern. In Kapitel 4 wird hierauf intensiv eingegangen.

3. Exkurs: Lineare und nichtlineare Systeme

Aus den bisherigen Beschreibungen folgt, dass das beschriebene Zukunftsszenario in einem erheblichen Maße von leistungselektronischen Anlagen dominiert wird, die wiederrum über ein Softwaremodul geregelt sind. Weiterhin ist zu erkennen, dass diese Anlagen eben nicht über inhärente, physikalisch stabilisierende Eigenschaften verfügen, sondern dass der Stabilitätsbeitrag aus der Qualität der Regelung selbst abzuleiten ist.

In einem klassischen Netzverbund liefern Synchronmaschinen, wie bereits beschrieben, netzstabilitätsdienliche Beiträge. Betrachten wir den stabilen Netzzustand nun als einen vektoriellen Arbeitspunkt mit einer Vielzahl an Parametern. Verändern sich einzelne Parameter, so stellt die Synchronmaschine in einem gewissen Rahmen sicher, dass die Anpassungsgeschwindigkeit der anderen Parameter des Vektors nicht eskalativ geschieht, sondern das Gesamtsystem:

- a) im Intervall der beherrschbaren Vektorzustände gehalten wird und

- b) das System einen neuen stabilen, prognostizierbaren Arbeitspunkt anfahren kann.

Weiterhin werden unerwünschte Resonanzeffekte gedämpft. Vereinfacht lässt sich aussagen, dass rotierende Masse in einem Netz das Verhalten des Netzes prognostizierbar macht und eine approximative, lineare Modellierung des Netzes zulässt. Zu beachten ist allerdings, dass auch in traditionellen Netzen unter bestimmten Bedingungen, beispielsweise bei Kurzschlüssen oder Überlastung, nichtlineare Effekte auftreten können.

Als linear wird ein System bezeichnet, bei dem das Antwortverhalten immer die gleiche Proportionalität gegenüber der Eingangsgröße hat, ein klassisches Beispiel wäre die Funktion

Betrachten wir in diesem Zusammenhang nun ein System mit mehreren Eingangsgrößen, also beispielsweise eine beliebige lineare Differentialgleichung mit einem mehrdimensionalen Eingangsvektor, wie dies in einem dynamischen elektrischen System unzweifelhaft der Fall ist, so lässt sich für jede Eingangsgröße einzeln die Ausgangsgröße ermitteln. Eine Addition der Ausgangssignale ergibt nun die Gesamtsystemantwort, was auch als Superpositionsprinzip bekannt ist.

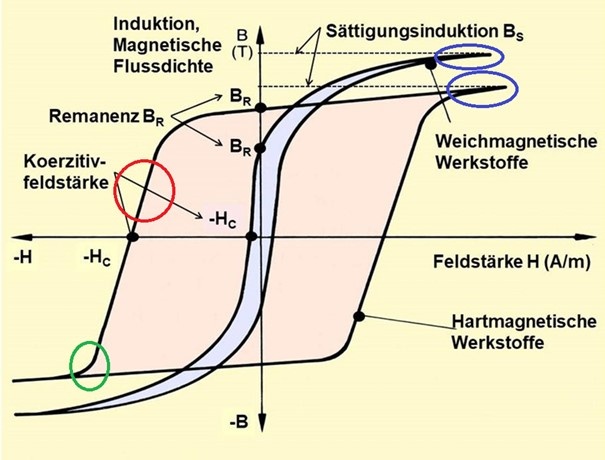

Im Gegensatz dazu ist ein nichtlineares System nun dadurch gekennzeichnet, dass das Antwortverhalten des Systems nicht proportional zu den Eingangsgrößen ist. Ein klassisches Beispiel sind hierbei etwa Hysteresekurven, wie in Abbildung 6 zu sehen. Der Begriff Hysterese stammt aus dem Altgriechischen und bedeutet „Zuspätkommen“, in einem physikalischen System ist hiermit gemeint, dass die Wirkung zeitversetzt gegenüber der Ursache auftritt und weiterhin vom Ausgangszustand des Systems abhängt.

Ein solches Verhalten ist typisch für ferromagnetische, magnetisch-leitfähige Materialien und Legierungen (Abbildung 6). Wird im Umfeld eines im Ausgangszustand nicht magnetisierten, ferromagnetischen Stoffs die Feldstärke H erhöht, so resultiert eine Erhöhung der magnetischen Flussdichte B. Sofern anschließend die Feldstärke wieder auf 0 reduziert wird, sinkt die Flussdichte auf einen Wert ab, der über 0 liegt. Der im Material beobachtbare Restmagnetismus wird als Remanenz bezeichnet. Somit ist ersichtlich, dass die Flussdichte B nicht nur von der Feldstärke H sondern auch dem Ausgangszustand abhängig ist.

Betrachten wir die Magnetisierung eines Körpers einmal als System. Dann ist, anhand der Randlinien in Abbildung 6, gut zu erkennen, dass es in diesem System lineare (rot) und nichtlineare (grün) Abschnitte gibt. Das System ist „stückweise linear“ und zeigt zunächst lineares Verhalten, das dann in einen nichtlinearen Zustand übergeht. Die zu erkennenden Spitzen (blau) zeigen Sättigung an. Eine Erhöhung der Feldstärke führt nicht zu einer zusätzlichen Magnetisierung, es ist ein materialspezifischer Höchstwert erreicht.

Zu beobachten ist dies bei einer Vielzahl von Bauteilen, beispielsweise Spulen mit Eisenkern. Je höher der Anteil an nichtlinearen Bauteilen ist, desto schwieriger ist es, das Antwortverhalten des Systems korrekt zu prognostizieren, da eben das Superpositionsprinzip keine Anwendung mehr findet.

Hieraus ist abzuleiten, dass die Modellbildung zur Prognose des Gesamtsystemverhaltens umso schwieriger wird, je weniger selbststabilisierende Eigenschaften die einzelnen Bestandteile des Gesamtsystems aufweisen. Besonders zu berücksichtigen ist hierbei auch das Risiko einer unprognostizierbaren Instabilität. Die Änderung einzelner Parameter kann dazu führen, dass ein eigentlich als linear und stabil angenommenes System in einen instabilen Zustand überführt wird, der schließlich ein Systemversagen bedingen kann. Kritisch ist hierbei, dass die zunehmende Instabilität des Systems über lineare Modelle nicht erkannt werden kann. Eine bekannte Beschreibung des Phänomens ist der Schmetterlingseffekt oder aber, systematisiert, die insbesondere von René Thom und Wladimir Arnold entwickelte Katastrophentheorie. Diese beschreibt, wie kontinuierliche Veränderungen plötzlich drastische, sprunghafte Umbrüche zur Folge haben. Sie klassifiziert diese abrupten Übergänge in einfache mathematische Modelle, die in verschiedenen Bereichen genutzt werden. Die Theorie hilft zu verstehen, wie kleine Veränderungen in einem System unerwartet große, oft irreversible Effekte auslösen können, etwa bei einem Durchbruch der Isolierung, bei Naturkatastrophen oder wirtschaftlichen Krisen.

Zur Abbildung sind daher zunehmend nichtlineare Simulationen und Modelle notwendig, die ein sehr tiefgreifendes Systemverständnis erfordern.

4. Die Roadmap Systemstabilität

Bis hierhin wurden im Beitrag technische und wissenschaftliche Grundlagen beschrieben. Im folgenden Abschnitt wird die Roadmap Systemstabilität nun kommentiert. Die Wertungen und Stellungnahmen sind Meinungen des Autors, abweichende Interpretationen sind möglich.

Ich möchte hier noch einmal kurz die zentralen Aussagen des technischen Grundlagenkapitels zusammenfassen:

Das Energienetz wird bis heute größtenteils über rotierende Synchronmaschinen gestützt. Synchronmaschinen bieten die notwendige Momentanreserve und dienen als Filter gegenüber unerwünschten physikalischen Effekten. Die Eigenschaften der Synchronmaschine erlauben ein gewisses zeitliches Delta, um auf Zustandsänderungen im Netz zu reagieren. Der Aufbau des Energienetzes folgt der Top-Down-Logik, die Einspeisung von Leistung erfolgt größtenteils auf den oberen Netzebenen. Die nachgelagerten Netzebenen wurden historisch so ausgelegt, dass diese den Transport von Leistung zum Verbraucher ermöglichen.

Die Roadmap Systemstabilität definiert sich selbst als „Fahrplan für einen stabilen Netzbetrieb mit 100 % Erneuerbaren“. Der Fokus liegt hierbei auf der technischen Umsetzung, Fragestellungen des Netzausbaus oder der Energiekosten sind nicht Gegenstand des Zielbildes der Roadmap (Abschnitt 4) und werden entsprechend, unter Würdigung der Bedeutung, im vorliegenden Beitrag zunächst nicht diskutiert.

Im Zielbild wird formuliert, dass das System „mit 100 % erneuerbaren Energien auch ohne konventionelle Kraftwerke betrieben werden kann“. Dies ist zunächst nicht mehr als eine Behauptung, soll jedoch für die Beurteilung der Roadmap als Diskussionsgrundlage dienen. Das hierbei beschriebene Zukunftsszenario weicht technisch und strukturell diametral vom zuvor beschriebenen, heutigen Ausgangszustand ab. In diesem hypothetischen Zukunftsnetz dominieren Stromrichter die Einspeisung, Synchronmaschinen sind entweder kaum oder gar nicht mehr im Betrieb. Das Top-Down-Prinzip der Energienetze ist nahezu vollständig aufgehoben, Einspeisung von Leistung erfolgt auf allen Netzebenen. Anstatt aus wenigen, zentralen Einspeisern und Netzstützen besteht es aus einer sich ständig ändernde Vielzahl an Erzeugern unterschiedlicher Leistungsklassen, die gemeinsam über die jeweilige Regelung und das möglichst fehlerfreie Reaktionsverhalten die Netzstabilität gewährleisten.

Hieraus folgen wichtige Erkenntnisse:

Die Komplexität in diesem Netz der Zukunft wird in erheblichem Maße zunehmen. Ohne Anlagen, die physikalisch direkt mit dem Netz gekoppelt sind und somit ein aus der Physik bedingtes Verhalten zeigen, muss jeder Anlage über ihre Regelung ein spezifisches Verhalten zugewiesen werden. Ohne dämpfende, physikalische Eigenschaften nimmt die Volatilität des Netzverbundes immer weiter zu, Systemzustandsänderungen oder Fehlerzustände müssen extrem schnell erkannt werden, um etwaige Gegenmaßnahmen einzuleiten. Elektrotechnische Phänomene werden nicht mehr passiv geglättet, sondern müssen aktiv erkannt und ausgeregelt werden. Hierzu ist es unabdingbar, das gesamte Verbundnetz, auf verschiedenen Ebenen, in Echtzeit zu überwachen und möglichst zeitnah Steuerbefehle zu übermitteln. Die notwendige Echtzeit-Kommunikation zwischen den einzelnen Netzbetreibern wird elementar. Hinzu kommt, dass das Leistungsangebot volatil wird und dem Leistungsausgleich, ohne oder mit nur sehr wenigen steuerbaren Erzeugern, zunehmend größere Bedeutung zukommt. Der Aspekt der Netzstabilität wird heterogenisiert und künftig von Erzeugern und Verbrauchern im Netz gewährleistet. Gigantische Datenmengen müssen hierzu erkannt, übertragen und ausfallsicher verarbeitet werden.

Zunächst, ein solcher, technischer Systemzustand ist grundsätzlich denkbar und auch nicht zwingend als instabil zu beurteilen. Zahlreiche Forschungsarbeiten beschäftigen sich mit masselosen Netzen, Solid State Grids und der Regelung von Stabilitätsphänomenen in leistungselektronisch dominierten Netzen und legen die grundsätzliche Machbarkeit nahe. Wie lange die hierzu notwendigen Forschungs- und Entwicklungsaufgaben jedoch noch dauern werden und mit welchen Unwägbarkeiten man dann bei der praktischen Umsetzung konfrontiert sein wird, ist jedoch wegen der extremen Komplexität kaum prognostizierbar. Faktisch ist es nicht weniger als der vollständige Umbau eines über mehr als ein Jahrhundert gewachsenen Energienetzes.

Strukturell werden die hieraus resultierenden Aufgaben in der Roadmap Systemstabilität klar beschrieben. In angemessener Qualität und sprachlich verständlich werden die technischen Grundlagen, Frequenz, Spannung, Winkelstabilität usw. dargestellt und so vermittelt, dass deren Bedeutung auch Fachfremden verständlich werden wird. Die resultierenden Ableitungen, wie den entsprechenden Aspekten in einem Zukunftsnetz Rechnung getragen werden kann und welche Herausforderungen sich im Wandel ergeben, sind grundsätzlich zutreffend und nachvollziehbar dargestellt. Auch werden die notwendigen Prozesse auf unterschiedlichen Ebenen sinnvoll charakterisiert. Der Leser bekommt eine technische Grundlage vermittelt, um zumindest die Grundaussagen und Ideen der Roadmap Systemstabilität begreifen zu können.

Weshalb besteht also Anlass zur Kritik? Anstatt auf der wissenschaftlichen Sachebene zu bleiben und diese zu vertiefen, wird die Roadmap zunehmend von politischen Wünschen und Zeitplänen konterkariert und geht, an den notwendigen Stellen, nicht in ausreichendem Maße in die Tiefe. Man gewinnt den Eindruck, als hätten zuerst Ingenieure und Wissenschaftler die Aufgabenstellungen beschrieben und politische Akteure nachfolgend ihre Wünsche und Träume im Text verankert. Vor allem die Vernachlässigung offensichtlicher Risiken sticht hier besonders heraus. Besonders hervorzuheben sind der Zeitplan, die mangelnde Genauigkeit bei der Risikobeurteilung, die unterkomplexe Darstellung der Anforderungen an die leistungselektronische Regelung sowie die beschriebenen Meilensteine. Laut Roadmap Systemstabilität sollten sämtliche Prozesse und Entwicklungsschritte im Wesentlichen bis 2030 abgeschlossen sein. Der Sinn hinter dem knappen Zeitplan besteht zweifellos darin, den Kohleausstieg auf 2030 vorzuziehen. Bezeichnet wird dies als „ambitioniert“, die aus Autorensicht richtige Beurteilung wäre „unseriös“.

Wenn man den derzeitigen Prozess der Energiewende als Projekt darstellt, dann bricht die Roadmap Systemstabilität hier mit den Prinzipien eines guten und verantwortungsvollen Projektmanagements. Es fehlen die Umsetzbarkeitsanalyse und Risikobeurteilungen. Können die gesteckten Ziele realistisch erreicht werden und falls nicht, was ist die Rückfallebene?

Insbesondere in den letzten Kapiteln der Roadmap Systemstabilität ist der mangelnde Realismus bei der Umsetzbarkeit der Meilensteine auffällig. Auch wird der Komplexität des Translationsprozesses, von der Beschreibung der Aufgabe, über die Definition der Randbedingungen, der Erarbeitung von Richtlinien bis zur realen Entwicklung und technischen Umsetzung im Feld völlig unzureichend Rechnung getragen.

Insgesamt werden in der Roadmap Systemstabilität 41 themenspezifische Stabilitätsprozesse definiert. In Kapitel 7 werden basierend hierauf 18 Meilensteine festgelegt. Hierbei gibt es prozessuale Meilensteine sowie technische Meilensteine. Während im technischen Grundlagenkapitel sehr dezidiert und weitreichend argumentiert wurde, lassen gerade die Meilensteine sowie die jeweiligen Stabilitätsprozesse ebenjene fachliche Tiefe vermissen.

Für die Umsetzung sind hierbei zumindest partiell neue technische Anlagen notwendig, von der Erzeugung, über das Netzmonitoring bis zum Netzschutz, die zum heutigen Zeitpunkt überhaupt nur in Teilen entwickelt sind. In der Konsequenz bedeutet das natürlich, dass niemand valide beurteilen kann, wie sich diese noch zu entwickelnden Anlagen im Betrieb konkret verhalten. Eine nicht unwesentliche Frage für eine Industrienation. Die notwendigen Kommunikationsprozesse, die für ein solches Netz notwendig werden, sind heute weder etabliert noch überhaupt vorgesehen.

Um dies zu belegen, möchte ich im Folgenden auf zwei Aspekte eingehen: Netzbildende Stromrichter sowie Digitalisierung, Datenerfassung, Regelung und IT.

Netzbildende Stromrichter

Vier von 18 Meilensteinen behandeln netzbildende Stromrichter. Dies sind Anlagen, die nicht mit einem bestehenden Netz synchronisiert werden müssen, sondern in der Lage sind, eigenständig ein Netz aufzubauen und die notwendigen Systemdienstleistungen zur Stabilisierung und zum Erhalt des Netzes zu liefern. Dies unterscheidet sie von heutigen (netzfolgenden) Anlagen, die üblicherweise einen konstanten Strom einspeisen und sich automatisch vom Netz trennen, wenn die Spannung beispielsweise zu stark oder zu lange einbricht. Derartige Stromrichter sind unter anderem in Balkonkraftwerken, aber auch großen PV-Installationen zu finden.

Wie bereits beschrieben, sollen netzbildende Stromrichter im Prinzip die Funktion von Synchronmaschinen ersetzen. Zwar sind erste netzbildende Stromrichter am Markt verfügbar, hierbei handelt es sich bisher aber eher um innovative Projekte und nicht um Massenmarktprodukte. Der Umstieg von netzfolgenden zu netzbildenden Stromrichtern sowie die Beurteilung notwendiger Stabilitätskriterien ist Gegenstand weltweiter akademischer Forschung[2]. Entsprechend stehen Erfahrungen in großen Netzverbünden noch aus. Aber auch weitere ungelöste Probleme sind zu erwähnen: Die beschriebenen Aspekte der Nichtlinearität werden nicht beachtet. Die Auswirkungen von Stromrichtern auf Bestandsinfrastruktur (auch hier insbesondere im nichtlinearen Bereich)[3] sind völlig unklar.

Und was bedeutet es, wenn instabile Netzzustände, die sich aus der fehlerhaften Netzzustandsanalyse und/oder Regelung des jeweiligen Wechselrichters ergeben können, nicht erkannt werden?

Die Zertifizierung und Abnahme, die in aller Regel mit stabilen Arbeitspunkten durchgeführt werden, liefern hierbei ebenfalls keinen erheblichen Erklärungsbeitrag. Auch muss klar formuliert werden, dass heute am Netz operierende Stromrichter stabile Arbeitspunkte im Bestandsnetz anfahren können. Ob dies mit einem zunehmend weichen, kurzschlussleistungsarmen Netz ebenfalls noch der Fall ist oder welche Anpassungen notwendig sind, ist in der Praxis nicht erprobt. Auch erfordern die im Grundlagenkapitel angesprochene Einkopplung von Oberwellen sowie das Resonanzverhalten des Netzes in Wechselwirkung mit dem Stromrichter besondere Aufmerksamkeit[4]. Leistungselektronische Anlagen zeigen, wie bereits erwähnt, kein inhärentes, stabilisierendes Verhalten, sondern sind über die entsprechende Regelungssoftware im Prinzip beliebig manipulierbar. Dies hat ernstzunehmende Konsequenzen. Die Anlagen müssen in der Lage sein, den vorliegenden Netzzustand richtig zu erkennen, um dann fast zeitgleich das im jeweiligen Zustand ideale Antwortverhalten zu zeigen. Hierauf wird in 2. Digitalisierung, Datenerfassung, Regelung und IT intensiver eingegangen.

Dessen ungeachtet erklärt die Roadmap, dass die Prüfgrundlagen zur Zertifizierung (MS2) bereits im Jahr 2024 abgeschlossen sein werden, Erfahrungen im Feld mit netzbildenden Stromrichtern dann bis 2027 (MS13) vorliegen und bereits im Jahr 2030 netzbildende Stromrichter einen signifikanten Beitrag zur Netzstabilität (MS18) leisten sollen. Allein die aufwendigen Genehmigungsverfahren, die Bauzeit sowie die Ressourcenknappheit am Weltmarkt sprechen dagegen, dass bis zum Meilenstein 2027 entsprechende Anlagen in einem für aussagekräftige Studien notwendigem Umfang überhaupt gebaut werden könnten. Es ist wenig sinnvoll, einen Pilotbetrieb in einem Netzverbund zu erproben, in dem weiterhin zu einem signifikanten Maße rotierende Synchronmaschinen arbeiten.

Digitalisierung, Datenerfassung, Regelung und IT

Unter diesem Oberpunkt lassen sich mehrere Meilensteine summieren. Konkret beschreiben die Meilensteine die praktische Umsetzung der im Grundlagenkapitel dargestellten Anforderungen an die Netzzustandsanalyse. Netzzustandsanalyse beschreibt die softwaregestützte Analyse des aktuellen Netzzustands, idealerweise im Vergleich mit einem Sollzustand, um Abweichungen zu erkennen und Reaktionsmöglichkeiten abzuleiten. Hierzu sind die Erfassung und Verarbeitung extrem großer Datenmengen in hoher Qualität notwendig.

Nach Kenntnisstand des Autors existieren zum heutigen Zeitpunkt zwar theoretische Konventionen zur Weitergabe des statischen Netzmodells, dies ist jedoch nicht gelebte Praxis. Auch sind die Echtzeitsimulation von Netzen sowie die Echtzeiterfassung heute überhaupt nicht etabliert. In den vergangenen Monaten sorgte bereits der Rollout von Smartmetern, einem vergleichsweise kleinen Projekt, für eine Vielzahl an Problemen und Unwägbarkeiten, die medial umfangreich rezipiert wurden.

Während es also aktuell Verteilnetzbetreibern, beispielsweise auf der Niederspannungsebene, überhaupt nicht möglich ist, die realen Netzzustände abzubilden, sollen diese bereits 2026 in Konzepte zu einem etwaigen Netzwiederaufbau nach einem Blackout eingebunden sein. Hierzu müssten die jeweiligen Netzbetreiber (gemeint sind dann auch beispielsweise Stadtwerke) über gänzlich andere Steuerungsmethoden, insbesondere zur Netzbildung, verfügen. Ein solcher Netzwiederaufbau, rein auf Basis von Leistungselektronik und ohne konventionelle Kraftwerke ist, soweit der Kenntnisstand des Autors, in großen Industrieländern noch niemals geschehen oder erprobt worden. In Deutschland gibt es derzeit über 880 Verteilnetzbetreiber, deren Kommunikations-, Handlungsprozesse und IT-Kapazitäten (dies umfasst insbesondere die Bereiche Simulation und Netzführung) entsprechend synchronisiert werden müssten.

2028 soll dann mit dem Dynamic Stability Assessmeent die Netzzustandsanalyse in Echtzeit erfolgen und auf prognostizierte kritische Stabilitätsphänomene aus dem Netzbetrieb heraus reagiert werden können (Punkt B3).

Es ist stringent, dass je nach Größe des Netzverbundes entweder eine entsprechende Echtzeitsimulation des Netzabschnittes erfolgen müsste, wobei der Algorithmus eine Antwort auf das erkannte Stabilitätsphänomen findet, oder aber sicherzustellen ist, dass Stabilitätsphänomene zuverlässig erkannt und anlagenseitig automatisch ausregelt werden.

Methoden hierfür wären beispielsweise der digitale Zwilling, also die digitale ideale Nachbildung eines Netzverbundes sowie die Perfect State Estimation, also die softwaregestützte, quasi-perfekte Vorhersage von Netzzuständen. So ließe sich, mit einem perfekten Modell, erkennen, ob Netzfehler vorliegen oder das Netz auf instabile oder schwierig zu beherrschende Zustände zusteuert. Die Umsetzung dieser Konzepte ist Teil aktueller Entwicklungsprojekte. Hierbei bestehen noch eine Vielzahl an Unklarheiten, insbesondere über die notwendige Modellqualität, die Granularität der Datenerfassung und zahlreiche weitere Aspekte. Ein Rollout im Jahr 2028 ist völlig unrealistisch.

Der gesamte Aspekt der digitalen Erfassung und Steuerung hinterlässt zahlreiche Fragezeichen. Die Roadmap Systemstabilität sieht den Aspekt der Systemstabilität (Abschnitt Verlagerung und Dezentralisierung, Seite 29) künftig als Gemeinschaftsaufgabe, an der alle Netzteilnehmer beteiligt werden „müssen“. Wie in B3 ausgeführt, soll dies bis 2028 geschehen sein. Die Komplexität dieses Vorhabens kann gar nicht überbewertet werden. An dieser Stelle sei auf den Abschnitt über nichtlineares Verhalten und Katastrophentheorie verwiesen. Für einen Erfolg müsste die Möglichkeit bestehen, an allen relevanten Netzknoten, in letzter Instanz eigentlich sogar an jedem Netzknoten den Netzzustand zu erfassen, die erfassten Daten an eine zentrale Rechneranlage zu übermitteln und dort zu analysieren. Im nächsten Schritt müssten Steuerungsmöglichkeiten bestehen, um jeden Netzknoten regeln und schalten zu können. Dies umfasst sowohl die Verbindung als auch den physikalisch notwendigen Schaltmechanismus selbst. Die Rechneranlage müsste weiterhin exakt abschätzen können, beispielsweise bei einem sich abzeichnenden, instabilen Netzzustand, welche Effekte mit welcher Regelung an welchen Netzknoten ideale Ergebnisse bringen. Und das bundesweit, in Echtzeit.

Es ist nachvollziehbar, dass das Konzept in einer nahezu endlosen Komplexität endet. Hier sei insbesondere auch der Aspekt Cyber-Security genannt. Wie kann im Falle eines Ausfalls der Kommunikationsinfrastruktur ein Netzbetrieb aufrechterhalten werden? Was geschieht, wenn eine derartige, zentrale Rechneranlage beispielsweise gewaltsam abgeschaltet wird und keine Redundanz mehr besteht?

Eine sinnvolle Antwort hierauf wäre, die Kommunikation mit Anlagen auf ein Mindestmaß zu reduzieren, um so, beispielsweise im Inselbetrieb und im Betrieb ohne Kommunikation, robust und resilient zu arbeiten. Hierzu wäre es notwendig, dass jeder am Netz beteiligte Stromrichter ein möglichst gleiches, prognostizier- und planbares Verhalten zeigt. Zentral für die Umsetzung dieser Aufgabe ist die Qualitätsprüfung der Regelung. Die Regelung ist, wie zuvor beschrieben, im Prinzip eine Software, die ein nahezu beliebig flexibles Verhalten der Anlagen ermöglicht. Um nun valide Aussagen über das Verhalten der Software zu treffen und hier insbesondere im Verbund mit anderen Anlagen, sind zwei Dinge notwendig: Die Modellierung (dies geschieht als DLL, im Prinzip ein Stück ausführbare Software) des Anlagenverhaltens müsste standardisiert sein. Hierbei wäre sicherzustellen, dass die DLL auch das reale Verhalten des Stromrichters abbildet. Hersteller sollten hier angehalten werden, den Code der realen Regelung zu übergeben und kein Ersatzmodell zu konstruieren. Die in Deutschland stark verbreitete „Trust the vendor“-Mentalität hat sich in der Vergangenheit als ausgesprochen kritisch erwiesen. Im nächsten Schritt wäre sicherzustellen, dass die Simulation von diversen Szenarien auf Grundlage eines genauen Netzabbildes des jeweiligen Netzbetreibers erfolgt. Weiterhin wäre es sinnvoll, ein verbindliches Kennlinienverhalten festzulegen, um sicherzustellen, dass sich Anlagen am Netz möglichst gleich und prognostizierbar verhalten, beispielsweise bezogen auf ihren Wirkleistungsbeitrag. Hierzu wäre es jedoch notwendig, möglichst genaue Spezifikationen festzulegen, als technische Anforderungen, die Hersteller entsprechend einzuhalten haben. Die softwareseitige Simulation mit Worst-Case-Szenarien erlaubte dann Aussagen über das zu erwartende Verhalten im Netzbetrieb.

Die Anlage müsste in diesem Fall auch über eine zuverlässige Netzzustandserkennung verfügen. Denkbar sind eine Vielzahl von ungewünschten Netzzuständen, die erkannt werden müssen. Eine Anlage muss weiterhin in der Lage sein zu erkennen, dass oder ob sie selbst ursächlich für einen ungewünschten Netzzustand ist. Ein sehr reales Beispiel hierfür ist die Inselnetzbildung in der Niederspannung. Bedingt durch den sehr hohen Anteil an Leistungserzeugern, beispielsweise PV-Balkonkraftwerken, sind Betriebszustände denkbar, in denen einzelne Netzabschnitte vollständig autarke Inselnetze aus Erzeugern und Verbrauchern bilden. Verliert dieser Netzabschnitt die Verbindung mit dem vorgelagerten Netz, so droht je nach Netztopologie auch ein Wegfall der Erdung des Abschnittes. Hieraus resultiert eine erhebliche Gefahr für Leib und Leben, zumal die Fehlererkennung nicht mehr zwangsläufig gegeben ist. Bereits im Mai 2016 wies der VDE|FNN[5] auf das Risiko hin, die BNetzA[6] sowie verschiedene Forschungseinrichtungen thematisieren den Aspekt regelmäßig.

Dies ist heute jedoch nicht der Fall und erste Netzbetreiber sind gerade dabei, entsprechende Entwicklungsprojekte überhaupt anzustoßen. Die hier besprochenen Aspekte bedingen einen tiefgreifenden Wandlungsprozess und Paradigmenwechsel innerhalb der Industrie und bei allen beteiligten Netzbetreibern. Selbst die Integration entsprechender DLLs, sofern diese überhaupt geliefert werden, in Simulationssoftware ist ein hochaufwändiger Prozess, dessen Vereinfachung aktueller Entwicklungsgegenstand ist. Derzeit gibt es keine verbindlichen Absprachen zwischen Netzbetreibern und der Industrie zur Modellierung von Anlagen und der potenziellen Übergabe etwaiger Modelle, um das Anlagenverhalten und daraus aggregiert das Netzverhalten im Zeitbereich simulieren zu können. Es existieren auch keine einheitlichen Softwaresysteme, geschweige denn Konventionen zum Datentransfer. Hierbei ist insbesondere nicht der Soll-Betriebszustand relevant, sondern die Risikozustände. Was geschieht bei Cyberangriffen, wie können Datenverbindungen sicher und redundant ausgelegt werden, ist die Kommunikation bei einem Ausfall von beispielsweise 5G Netzen gesichert und wie lassen sich Anlagen selbst vor Angriffen schützen?

Was in der Roadmap lapidar mit einem Zeithorizont von zwei Jahren versehen wird, ist ein Gesamtprozess, dessen völlig unzweifelhafte Notwendigkeit gerade von ersten Netzbetreibern überhaupt erkannt wird und für dessen Umsetzung häufig weder Knowhow noch ernsthafte Bereitschaft besteht. Auch auf der Seite der Industrie bestehen massive Vorbehalte, da ein erheblicher Teil des Knowhows preisgegeben werden müsste.

Auch hier sei klar erwähnt, all dies ist aktuell Gegenstand von Forschung und Entwicklung. So zeigt beispielsweise der Abschlussbericht „Netzregelung 2.0“ des Fraunhofer IEE[7] auf, dass dies kein unrealistisches oder unerreichbares Szenario ist. Zeitgleich wird aber auch dort klar erwähnt, dass zunächst Grundlagenforschung notwendig ist. Das, was laut Roadmap Systemstabilität bis 2028 umgesetzt sein soll, ist nicht weniger als ein Jahrzehntprojekt.

Auffällig ist insgesamt die Fokussierung auf Leistungselektronik, ohne die bereits beschriebenen Risiken angemessen zu würdigen. Es hätte das Papier erheblich aufgewertet, konventionellere Lösungen zur Netzstabilisierung ebenfalls zu diskutieren. Beispielhaft zu nennen ist hierbei der zukünftige Einsatz rotierender Phasenschieber. In der Roadmap Systemstabilität wird diese Möglichkeit nur an einer Stelle, in einer Randbemerkung zu Kurzschlussströmen erwähnt. Rotierende Phasenschieber funktionieren ähnlich wie Generatoren, speisen jedoch keine Energie ein, da logischerweise der externe Antrieb fehlt. Der rotierende Phasenschieber bezieht die notwendige Energie aus dem Netz, in dem dieser synchron läuft. Viele der zuvor beschriebenen Phänomene und Problemstellungen, die auch in der Roadmap Systemstabilität intensiv diskutiert werden, ließen sich so massiv reduzieren. Wie relevant dieser Ansatz ist, zeigte sich jüngst daran, dass die TenneT im August 2024 die Siemens Energy mit dem Bau von acht derartigen Anlagen beauftragte. Eine Rekordvergabe. Auch im aktuellen EnWG-Entwurf wird der Aspekt erörtert und hierbei insbesondere die Möglichkeit, Bestandskraftwerke zu rotierenden Phasenschieberanlagen umzurüsten, positiv erwähnt.

Weitere Gedanken

Aus dem Gesamtprozess, der in der Roadmap Systemstabilität diskutiert wird, resultieren Fragestellungen, die in der notwendigen Komplexität vor dem Aspekt der Betriebssicherheit diskutiert werden müssen. Dass die Komplexität des Netzes der Zukunft erheblich zunimmt und gänzlich neue Anforderungen daraus resultieren, wird in der Roadmap an vielen Stellen erwähnt, die Tragweite jedoch wird nicht gewürdigt. Es werden weder Lösungen skizziert noch der aktuelle Ist-Zustand beschrieben, sondern lediglich eine Zeitvorgabe festgelegt, bis wann eine Lösung gefunden sein muss. Eile und fixe Terminpläne sind nach Überzeugung des Autors auch hier ausgesprochen gefährlich.

Und es gibt weitere Kritikpunkte an der Roadmap Systemstabilität, die erwähnt werden müssen. Das Papier geht nicht in der notwendigen Tiefe darauf ein, dass ein „dargebotsabhängiges“, also auf Wind und Sonne basierendes, Energiesystem logischerweise eine unendliche Anzahl an verschiedenen Netzzustände und Arbeitspunkten erreichen kann, wobei die Komplexität mit jeder Anlage steigt und in der Anforderung einer immer präzisieren Netzzustandsanalyse, wie zuvor beschrieben, resultiert. Es wird unterstellt, dass diese gigantische Aufgabe einfach machbar ist. Auch hier sei erwähnt, dass Systemdienstleistungen nur erbracht werden können, wenn auch die notwendige Leistung bedarfsgerecht vorgehalten wird. Völlig unabhängig von der Uhrzeit oder dem Wetter. Sofern dies über leistungselektronische Anlagen geschehen soll, wird hier eine entsprechende Energiespeicherung benötigt. Die hierfür notwendigen Konzepte, angefangen von der Regelung bis zur technischen Umsetzung, müssen entwickelt und angestoßen werden.

Um das Ziel, ein CO2-neutrales Energiesystem aufzubauen, zu erreichen, wäre eine andere Herangehensweise notwendig. Sofern dies als staatliches Ziel definiert wird, müssen auch staatliche Forschungs- und Entwicklungsaufträge im notwendigen Maße angestoßen, finanziert und begleitet werden.

Und hier soll nun auf zentrale Hürden verwiesen werden. Zahlreiche der angesprochenen Prozesse und technologischen Ideen befinden sich irgendwo zwischen Grundlagenforschung und akademisch begleiteter Entwicklung. Um diesen Prozess bis 2030 zum Erfolg zu bringen, müssten erhebliche Forschungskapazitäten freigeräumt und finanziert werden. Dies über die derzeit gängige Drittmittelforschung zu gewährleisten in der Hoffnung, dass die Projekte die richtige Lösung abwerfen, ist insbesondere vor dem Hintergrund des veranschlagten Terminplans abwegig. Dies umfasst im nächsten Schritt dann die Einbindung der Industrie, die in der Lage sein muss, den Anlagenbedarf zu produzieren, anzuschließen und zu testen. Die Roadmap erweckt nicht den Eindruck, als sei die Tragweite der formulierten Forderungen und hieraus abzuleitenden Folgeprozesse wirklich erfasst.

Dass Zweifel an der Umsetzbarkeit bestehen, zeigt sich nicht zuletzt darin, dass die BNetzA[8] im Dezember 2023 mehreren Betreibern untersagte, Kohlekraftwerke vor 2031 stillzulegen und so den von der Bundesregierung avisierten Kohleausstieg vorzuziehen. Ursächlich, so BNetzA, sei die Systemrelevanz der Anlagen für die Netzstabilität. Es ist gut möglich, dass ein zulässiges Abschaltdatum, insbesondere vor dem Hintergrund des schleppenden Zubaus an Gaskraftwerken, noch deutlich in Richtung 2040 geschoben wird.

Überhaupt entsteht der Eindruck, als bestünde die Bereitschaft, die notwendige Sorgfalt dem Primat eines künstlichen Termindrucks unterzuordnen. Nach einem sehr guten, fundierten Grundlagenkapitel werden die Aussagen der Roadmap immer universeller und oberflächlicher. Es werden Oberziele formuliert, ohne auf die Komplexität in der Tiefe einzugehen. Es droht die Gefahr, dass eine Vielzahl an Subprozessen und Projekte angestoßen werden, die nicht koordiniert in die gleiche Richtung arbeiten.

Auch muss hinterfragt werden, ob es wirklich eine kluge Idee ist, die beschriebenen Strukturen und Mechanismen direkt für den gesamten Netzverbund ausrollen zu wollen, bevor Erfahrungen im realen Netzbetrieb mit unterschiedlichen Netzzuständen vorliegen. Eine mögliche Idee bestünde darin, den Betrieb, primär mit Leistungselektronik, in kleineren Netzarealen zu erproben und das Netz nach Risikogebieten zu clustern. Je mehr Lastwechsel in einem Netzareal auftreten, je größer die Anzahl an Verbrauchern und je stärker die Gradienten der Laständerungen sind, desto komplexer die Netzdynamik selbst. Hieraus ließen sich Gebiete erkennen, in denen mit geringerem Risiko der Netzbetrieb und Netzaufbau rein mit Leistungselektronik erprobt werden kann, ohne direkt kritische Netzareale zu gefährden. Ein solcher Testbetrieb und Inselbetrieb wird im Abschnitt V2 erwähnt, der Komplexität der Aufgabe genügt aber auch diese Beschreibung nicht. Feldtests bergen Risiken wie den Ausfall oder die Beschädigung von Anlagen und können so die Infrastruktur einer Region empfindlich stören. Dies ist mit einer Vielzahl von Akteuren zu koordinieren, dies umfasst Rettungsdienste, städtische und kommunale Dienste, sprich alle Akteure, die im Notfall an der Aufrechterhaltung oder Wiederherstellung der Infrastruktur beteiligt wären. Derartige Planungen und Versuche, die ohnehin erst durchgeführt werden können, wenn die entsprechenden Anlagen betriebsbereit sind, haben Jahre an Vorlauf. Die Roadmap sieht den Abschluss des Arbeitspaketes bis Ende 2025 vor. Angesicht des offensichtlichen Risikos eines Systemversagens, was im vorliegenden Fall der Blackout wäre, erscheinen Erprobungsfristen von wenigen Monaten bis zu maximal zwei Jahren extrem risikofreudig und unterstellen indirekt eine äquivalente Risikofreudigkeit auf Seiten der Verbraucher.

Der zeitliche Bedarf von Wissenschaft und technischer Entwicklung lassen sich nicht per Dekret lenken und vorschreiben. In der Roadmap wird erwähnt, dass hierzu notwendige Ressourcen „parallel einzuplanen“ sein, um die notwendigen Prozesse umzusetzen, nicht aber, woher diese Ressourcen kommen sollen. Ressource, das sind im vorliegenden Fall nicht nur Geldmittel, sondern insbesondere auch Mitarbeiter.

Nahezu sämtliche Prozesse und Mechanismen erfordern technisches Personal, in aller Regel studierte Ingenieure oder IT-Experten. Dies sind Spezialisten, um die bereits heute auf dem Weltmarkt massiv konkurriert wird und die regelmäßig über Überlastung klagen. Nach Umfrage des IFO-Institutes von April 2024[9] ist das Ingenieurwesen sogar der am stärksten vom Fachkräftemangel betroffene Bereich. Viele technische Unternehmen suchen bereits heute technische Fachkräfte, das Bestandspersonal ist oftmals vollständig in Unternehmensprozessen und Projekten gebunden. Ob die an den Prozessen beteiligten Stakeholder die notwendigen Personalkapazitäten der beschriebenen Mammutaufgabe freiräumen können, ist definitiv zweifelhaft.

Auch hier verliert sich die Roadmap schließlich in Floskeln und spricht vom „Engagement aller Akteure“, die gemeinsam, engagiert und konstruktiv das Ziel nur zusammen erreichen können. Praktisch wird ein, mit dem überhasteten Atomausstieg, dem geplanten Kohleausstieg sowie einer übergroßen Vielzahl von häufig fachfremden, politischen Wünschen ein Problem erzeugt, dessen Lösung jetzt in einem völlig surrealen Zeitrahmen von Ingenieuren und zahlreichen weiteren Akteuren der Energiewirtschaft erbracht werden soll. Es ist völlig richtig, dass ein „hoher Handlungsdruck“ besteht, diesen jedoch durch offensichtlich unerreichbare Terminpläne und unterkomplexe Beurteilungen der zu erarbeitenden Lösungen künstlich zu steigern, erscheint wenig zielführend.

Positiv hervorzuheben ist die häufige Fokussierung auf Marktmechanismen und die marktgestützte Beschaffung von Dienstleistungen und erkannten Bedarfen. Ohne unnötige technologische Eingrenzung wird es so möglich, vom weltweiten Innovationspotential und der Schöpfungskraft des Marktes zu profitieren.

In der Einleitung wurde erwähnt, dass zunächst nicht auf das Thema Netzausbau sowie die zu erwartenden Kosten eingegangen wird. Dies muss jedoch hier, wenigstens kurz, geschehen. Wie im Eingangskapitel beschrieben, ist Netzstabilität im Prinzip der fortwährende Ausgleich zwischen Erzeugern und Verbrauchern, unter Berücksichtigung von Randbedingungen und Netzphänomenen. Um dies zu ermöglichen, muss die notwendige Infrastruktur gegeben sein. Netzstabilität benötigt zunächst ein Netz, sprich die physikalischen Komponenten. Das klingt nach einer Binsenweisheit, bezieht sich jedoch auf ein reales Problem.

Dies ist derzeit nicht der Fall. Die Beispiele sind zahllos. Im Mai 2024 titelte etwa der SWR „Hohe Netzauslastung: TransnetBW rief zum Stromsparen auf“[10]. Bereits heute bestehen häufig und deutschlandweit Netzengpässe, die eine Verteilung der erzeugten Energie unmöglich machen. Aus einer Antwort der Bundesregierung auf eine Anfrage ging im Oktober 2023 hervor, dass ein Viertel der Offshore erzeugten Windkraft im ersten Quartal 2023 abgeregelt wurde[11]. Abgeregelt bedeutet, dass Anlagen ausgeschaltet werden, da man die Leistung nicht verteilt bekommt. Ursächlich war insbesondere ein Netzengpass zwischen Niedersachsen und Nordrhein-Westfalen.

Die BNetzA sprach im Juni 2024 von notwendigen Investitionen in Höhe von mindestens 320 Milliarden Euro bis zum Jahr 2045. Bereits heute sehen sich Netzbetreibern einer Flut von Klagen gegenüber, sobald neue Stromtrassen geplant werden. Aus den zuvor beschriebenen und notwendigen Entwicklungsprojekten werden weiterhin technische Anforderungen resultieren, deren Kosten logischerweise noch nicht abgeschätzt werden können. Auch diese Kosten sind zu stemmen und bergen politische, finanzielle und verwaltungsrechtliche Fragen, deren Umfang derzeit überhaupt nicht absehbar ist. Dies wird zu Debatten und somit Verzögerungen in erheblichem Maße führen.

Die getroffenen Aussagen erwecken möglicherweise den Eindruck einer überwiegend negativen Rezension der Roadmap Systemstabilität. Dies möchte ich hier noch einmal differenzieren. Die Roadmap Systemstabilität liefert ein hervorragendes technisches Grundlagenwerk und formuliert erstmals die, für das genannte Szenario, notwendigen Entwicklungsschritte in Prozesse. Formuliert wird aber auch eine völlig überzogene, unterkomplexe und unseriöse Erwartungshaltung, die zentrale Fragestellungen unbeantwortet lässt und sich in unbelegte Behauptungen flüchtet.

Zum Schluss ein persönliches Wort: Ich bin im Ruhrgebiet zwischen den Hinterlassenschaften des Bergbaus aufwachsen, habe Tagebrüche erlebt und die Folgen von jahrzehntelanger Kohleverstromung gesehen. Darunter leidet das Ruhrgebiet bis heute. Man denke an die Belastungen der Böden und den politisch völlig verpatzten Strukturwandel. Der Umstieg auf eine möglichst emissionsfreie und ressourcenschonende Energieerzeugung ist alternativlos und nicht nur maßgeblich für den Wirtschaftsstandort Deutschland, sondern auch für den Umweltschutz weltweit. Wenn die in der Roadmap formulierten Prozesse und Ziele genutzt würden, um Innovationen anzustoßen und die ingenieurwissenschaftliche Kapazität Deutschlands zu stärken, dann wäre viel erreicht. Dies kann aber unmöglich auf Kosten eines sicheren, zuverlässigen Systembetriebs geschehen. Dem entgegen stehen auch Verpflichtungen Deutschlands auf europäischer Ebene[12], auf die hier aber nicht weiter eingegangen werden soll.

Hierfür ist aber Realitätssinn bei der Umsetzung, bei der Beurteilung von Zeitplänen und insbesondere der Risikobewertung notwendig. Die Physik hat kein Parteibuch. Forschungs- und Entwicklungsprozesse lassen sich, auch mit Geld, nicht beliebig beschleunigen. Der denkbar größte Schaden, der sich dem Ziel des Umstiegs auf emissionsarme Energieerzeuger zufügen ließe, wäre ein Blackout, ein unplanbarer, unzuverlässiger Systembetrieb oder aber reale Schäden an Leib und Leben.

Und an dieser zentralen Stelle wird die Roadmap Systemstabilität den anstehenden Aufgaben nicht gerecht.

Der Beitrag erschien erstmals im atw – International Journal for Nuclear Power, Ausgabe 6 2024 (Vol. 69)

Fußnoten:

[1] Bei der Netzankopplung von Windkraftanlagen bestehen verschiedene Konzepte, wobei die doppelt gespeisten Asynchrongeneratoren (DFIG) sowie Vollumrichter derzeit dominieren. Bei DFIG besteht eine partielle AC-Direktankopplung an das Netz, zur Veranschaulichung der Funktionsweise von Leistungselektronik wird auf ausführlichere Erklärungen, die hier den Umfang sprengen würden, verzichtet.

[2] Quellenverweise: Grid-Following and Grid-Forming Control Schemes & The grid-forming approach

[3] Quellenverweis: Harmonic Sources Modelling

[4] Quellenverweise: Harmonic Compensators & Harmonic Frequencies Decoupled Control Scheme

[5] Quellenverweis: VDE zur Inselnetzerkennung 2016

[6] Quellenverweis: BNetzA-Stellungnahme BK6-23-010

[7] Quellenverweis: Netzregelung 2.0 – Fraunhofer IEE

[8] Quellenverweis: Welt zur BNetzA

[9] Quellenverweis: All-Electronics zur IFO-Umfrage

[10] Quellenverweis: Netzauslastung TransnetBW

[11] Quellenverweis: Abgeregelte Offshore-Erzeugung

[12] Quellenverweis: Verpflichtungen Deutschlands im Rahmen der ENTSO-E

Quellen:

WELT zur BNetzA

Verpflichtungen Deutschlands im Rahmen der ENTSO-E

- https://www.bundesnetzagentur.de/DE/Beschlusskammern/1_GZ/BK6-GZ/2013/BK6-13-200/Datenorg_10_bf.pdf?__blob=publicationFile&v=2

- https://www.entsoe.eu/network_codes/

Abgeregelte Offshore-Erzeugung

Netzregelung 2.0 – Fraunhofer IEE

https://publica.fraunhofer.de/bitstreams/e896f01e-5192-41d7-b8e0-4b8f075225c6/download#page=23

Netzauslastung TransnetBW

https://www.swr.de/swraktuell/baden-wuerttemberg/transnetbw-hohe-netzauslastung-stromsparen-100.html

Harmonic Frequencies Decoupled Control Scheme

https://ieeexplore.ieee.org/abstract/document/10564131

Harmonic Sources Modelling

https://www.sciencedirect.com/science/article/abs/pii/S0378779623001232

The grid-forming approach

https://ietresearch.onlinelibrary.wiley.com/doi/full/10.1049/gtd2.12430

Grid-Following and Grid-Forming Control Schemes

https://sciendo.com/article/10.2478/pead-2023-0001

Harmonic Compensators

https://www.sciencedirect.com/science/article/pii/S2665917423003458

All-Electronics zur IFO-Umfrage

BNetzA Stellungnahme BK6-23-010

VDE zur Inselnetzerkennung 2016